点击左侧边栏的入图,可将不同来源的数据导入至嬴图数据库。支持的数据源包括CSV、JSON、JSONL、PostgreSQL、SQL Server、MySQL、BigQuery、Neo4j以及Kafka。

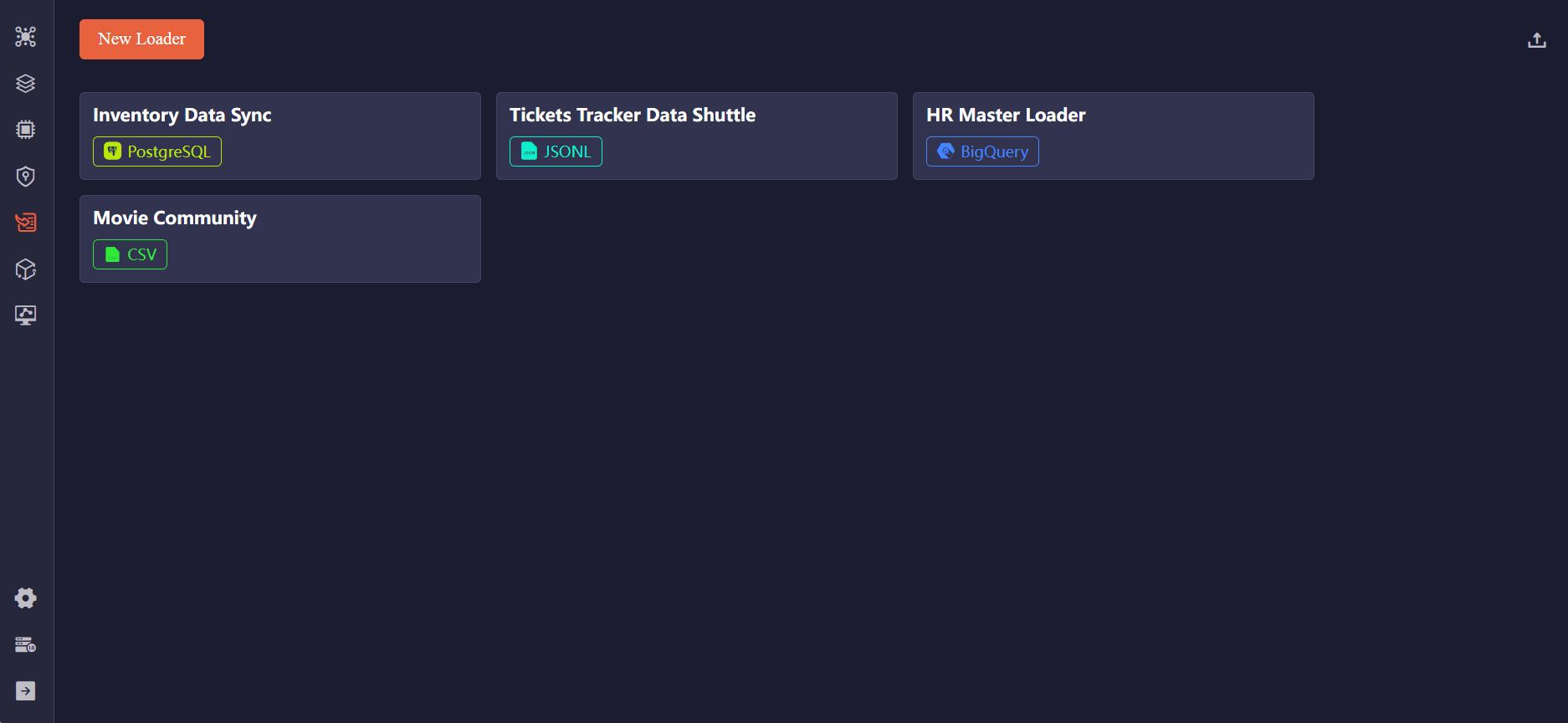

创建Loader

点击New Loader按钮创建新Loader。在Loader配置页面,点击Loader名称后的设置图标即可修改Loader的名称和描述。

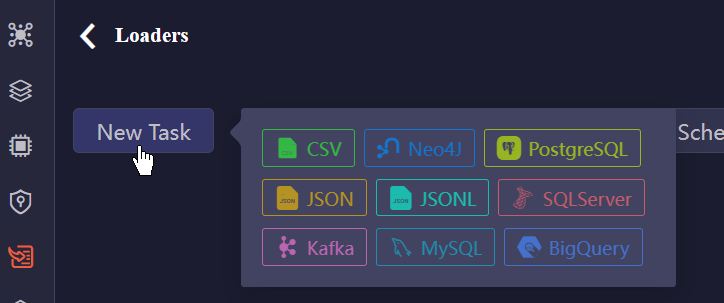

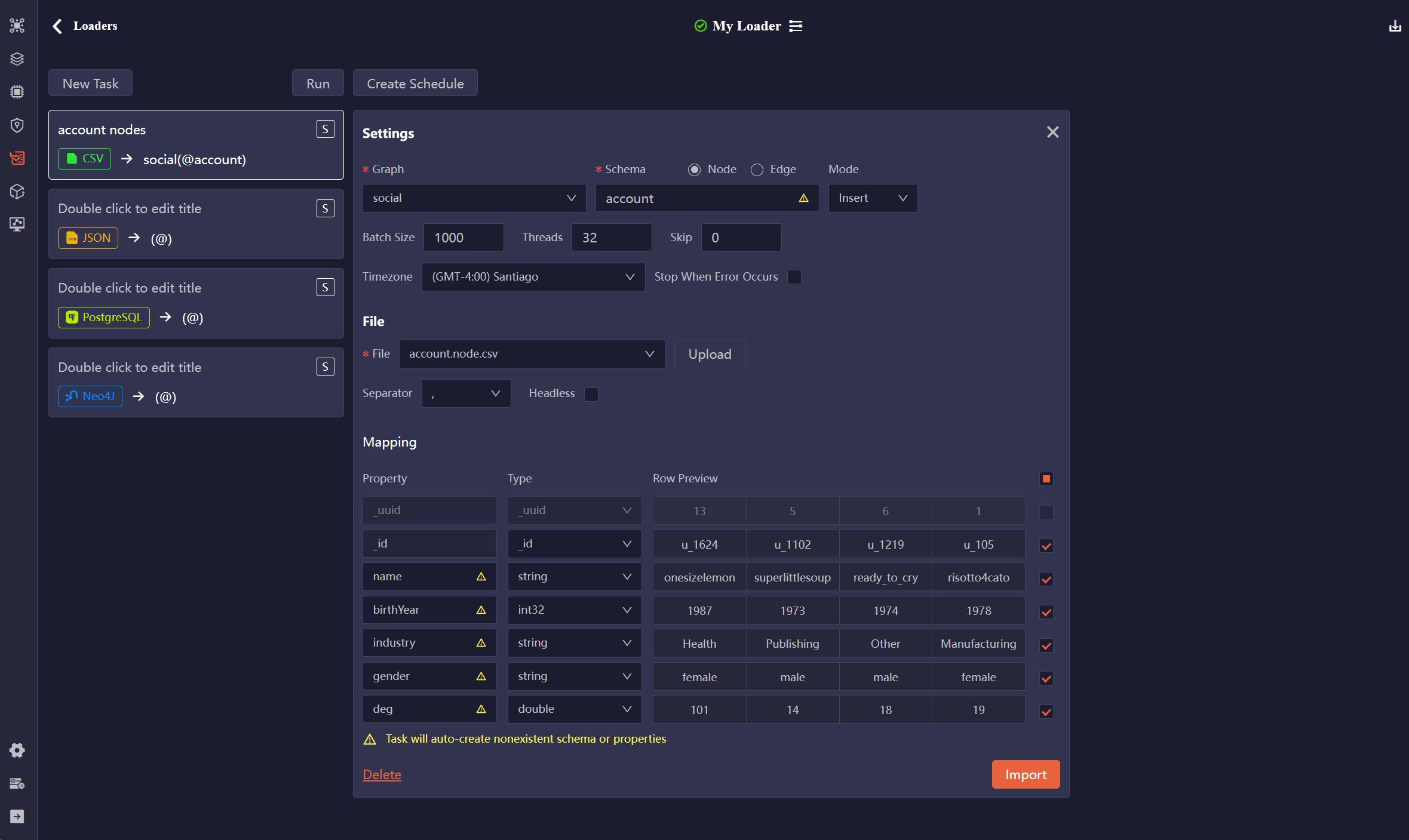

接下来即可为Loader创建任务。点击New Task按钮并选择源数据类型:

如需进一步配置任务,请参考任务配置。

导入数据

导入单个任务

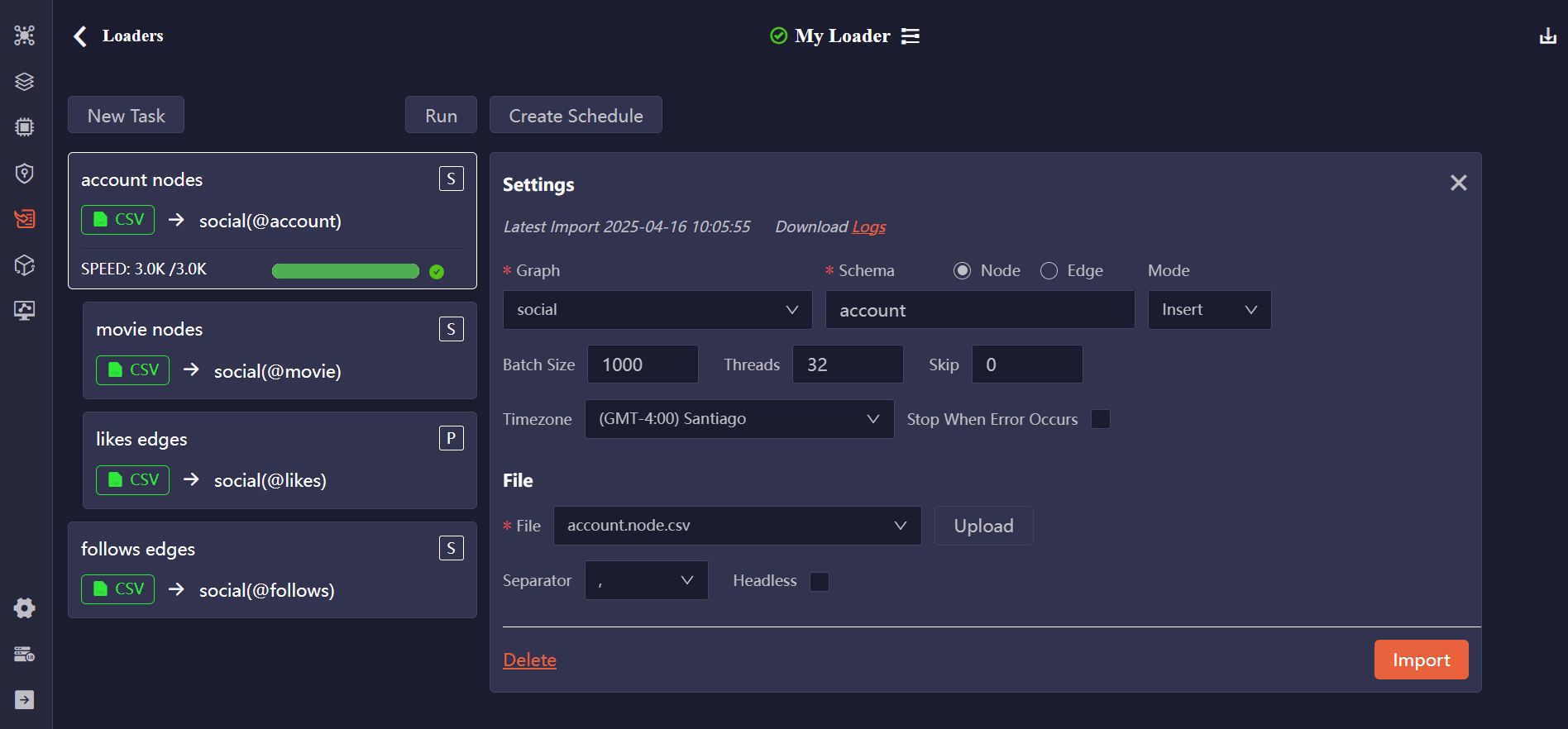

在任务配置面板,点击导入按钮,即可执行单个导入任务。

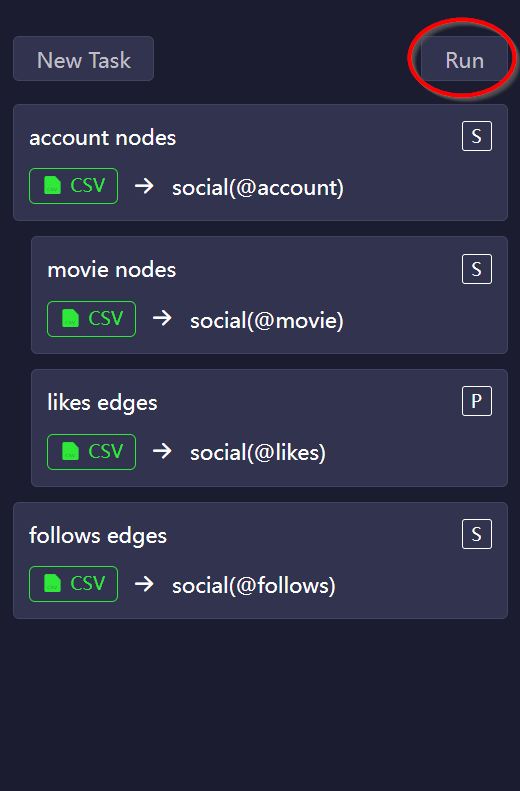

运行Loader

点击任务列表顶部的运行按钮,即可批量运行Loader中的所有导入任务,任务的运行顺序和处理模式如下:

- 任务自上而下运行,可拖拽任务卡片改变其顺序。

- 点击任务卡片上的

S(串行)或P(并行)标签来指定任务处理模式。 - 相邻的

P类型任务连同其之前的S类型任务会组成并行任务组,并行导入。

同时导入点和边,可能会引发报错,因为创建边时需保证其端点在图中存在。为避免此类问题,建议先导入点,再导入边,或确保正确配置若不存在则创建节点选项,且导入模式根据需求设置为

Insert、Upsert或Overwrite。

导入日志

导入成功后,进度条为绿色。如果导入过程中出现错误,进度条的一部分会变成黄色,代表失败数据行所占比例。

最新的导入日志将展示在任务配置面板顶部,可在此下载日志以供进一步查看。

创建定时任务

您可创建定时任务,自动运行Loader。点击创建定时任务并配置触发策略:

- 执行模式:可选择仅执行一次,或设置为每周或每月重复执行。

- 时区:选择定时任务开始时所使用的时区。

- 开始时间:指定Loader执行任务的开始时间。

点击开始定时任务以激活任务。您可在运行日志中查看运行历史。

导入/导出Loader

您可导出Loader用作备份或分享,并在需要时快速恢复或复制其配置。

任务配置

每个任务配置包含以下两个部分:通用设置和源数据相关设置。

通用设置

项目 |

描述 |

|---|---|

| Graph | 选择一个已有图集 |

| Schema | 选择Node或Edge。Schema名称字段会根据所选图集中的schema自动填充。也可输入schema名称来创建新的schema |

| Mode | 选择导入模式:Insert,Upsert或Overwrite |

| Batch Size | 指定每批导入的数据行数 |

| Threads | 指定导入时最大线程数 |

| Timezone | 选择转换时间戳时使用的时区。默认为浏览器时区 |

| Stop When Error Occurs | 导入出错时,是否终止导入操作 |

| Create Node If Not Exist | 导入边时,是否自动创建缺失的端点。若未勾选,缺少端点的边将被跳过,引发导入报错。该选项仅导入边时可见 |

CSV, JSON, JSONL

文件

项目 |

描述 |

|---|---|

| File | 上传文件或选择此前上传过的文件 |

| Separator | 指定CSV文件的分隔符:,,;或| |

| Headless | CSV文件的首行是否包含属性名和类型。若未勾选,默认按照无表头处理(仅包含数据行) |

示例文件:

_id:_id,username:string,brithYear:int32

U001,risotto4cato,1978

U002,jibber-jabber,1989

U003,LondonEYE,1982

_from,_to,timestamp

risotto4cato,jibber-jabber,1634962465

LondonEYE,jibber-jabber,1634962587

[

{

"_id": "U001",

"username": "risotto4cato",

"brithYear": 1978

},

{

"_id": "U002",

"username": "jibber-jabber",

"brithYear": 1989

},

{

"_id": "U003",

"username": "LondonEYE",

"brithYear": 1982

}

]

[

{

"from": "risotto4cato",

"to": "jibber-jabber",

"timestamp": 1634962465

},

{

"from": "LondonEYE",

"to": "jibber-jabber",

"timestamp": 1634962587

}

]

映射

项目 |

描述 |

|---|---|

| Property | 编辑属性名。该字段会根据CSV文件表头(若有)的属性名或JSON/JSONL文件中的键名自动填充 |

| Type | 选择属性值类型。该字段会根据CSV文件表头(若有)指定的属性值类型自动填充。如果属性名在当前schema下已存在,则无法修改其类型 |

| Original | 展示JSON/JSONL文件中的键名,用作参考 |

| Row Preview | 预览前几行数据 |

| Include/Ignore | 取消勾选,则在导入数据时跳过该属性 |

PostgreSQL, SQL Server, MySQL

源数据库

项目 |

描述 |

|---|---|

| Host | 数据库服务器的IP地址 |

| Port | 数据库服务器的端口号 |

| Database | 要导入的数据库名称 |

| User | 数据库的用户名 |

| Password | 用户名对应的密码 |

| Test | 检查是否能成功连接数据库服务器 |

SQL

编写SQL语句从数据库获取数据,然后点击预览将结果映射为点属性或边属性。

映射

项目 |

描述 |

|---|---|

| Property | 编辑属性名。该字段会根据查询结果自动填充列名 |

| Type | 选择属性值类型。该字段会根据查询结果中的各列自动填充数据类型。若属性名在当前schema下已经存在,则无法修改其类型 |

| Original | 展示查询结果中的列名,用作参考 |

| Row Preview | 预览前几行数据 |

| Include/Ignore | 取消勾选,则在导入数据时跳过该属性 |

BigQuery

源数据库

项目 |

描述 |

|---|---|

| Project ID | Google Cloud Platform上的项目ID |

| Key (JSON) | 服务账户密钥,是一个JSON文件。上传一个JSON文件,或选择已上传的文件 |

| Test | 检查是否能成功连接数据库服务器 |

SQL

编写SQL语句从BigQuery获取数据,然后点击预览将结果映射为点属性或边属性。

映射

项目 |

描述 |

|---|---|

| Property | 编辑属性名。该字段会根据查询结果自动填充列名 |

| Type | 选择属性值类型。该字段会根据查询结果中的各列自动填充数据类型。若属性名在当前schema下已经存在,则无法修改其类型 |

| Original | 展示查询结果中的列名,用作参考 |

| Row Preview | 预览前几行数据 |

| Include/Ignore | 取消勾选,则在导入数据时跳过该属性 |

Neo4j

Neo4j

项目 |

描述 |

|---|---|

| Host | 数据库服务器的IP地址 |

| Port | 数据库服务器的端口号 |

| Database | 要导入的数据库名称 |

| User | 数据库服务器的用户名 |

| Password | 用户名对应的密码 |

| Test | 检查是否能成功连接数据库服务器 |

Cypher

编写Cypher查询语句从Neo4j获取数据,然后点击预览将结果映射到嬴图数据库。

映射

项目 |

描述 |

|---|---|

| Property | 编辑属性名。该字段会根据查询结果自动填充列名 |

| Type | 选择属性值类型。该字段会根据查询结果中的各列自动填充数据类型。若属性名在当前schema下已经存在,则无法修改其类型 |

| Original | 展示Neo4j中的属性名,用作参考 |

| Row Preview | 预览前几行数据 |

| Include/Ignore | 取消勾选,则在导入数据时跳过该属性 |

Kafka

Kafka

项目 |

描述 |

|---|---|

| Host | Kafka代理运行的服务器IP地址 |

| Port | Kafka代理监听传入连接的端口 |

| Topic | 发布消息(数据)的Topic |

| Offset | 选择偏移量以指定要消费(导入)的消息:

|

| Test | 检查是否能成功建立连接 |

| Preview | 将接收到的消息映射为点属性或边属性 |

映射

项目 |

描述 |

|---|---|

| Property | 编辑属性名。以消息内容中的英文逗号(,)划分属性,默认属性名为col<N> |

| Type | 选择属性值类型。若属性名在当前schema下已经存在,则无法修改其类型 |

| Row Preview | 预览前几行数据 |

| Include/Ignore | 取消勾选,则在导入数据时跳过该属性 |

Kafka的Task(消费者)开始后会一直保持运行来接收新发布的消息,需要时请手动停止。